東京大学大学院 情報理工学系研究科 鈴木研究室

准教授 博士(情報理工学) 鈴木 大慈

ルールベースから統計的学習へ

ビッグデータの活用とマシンパワーの増大により飛躍的な進歩を遂げた人工知能研究。鈴木大慈准教授の主な関心領域は、「統計的学習理論」だ。統計学と機械学習を中心に数理的なアプローチから研究を続けている。その動機の源泉は1990年代半ばにあった。ウィンドウズ95が登場し、パソコンが一家に一台置かれ、インターネットが張り巡らされていく――。それを見た鈴木准教授は「次にくるのは人工知能だろう」と予想した。以降、機械学習寄りの研究、統計学寄りの研究と多少の変遷はあるものの「人工知能の発展に貢献したい」という思いは一貫している。

統計的学習理論とは何か。80〜90年代、人工知能といえば「ルールベース」が主流だった。これは「この条件下ではこうする」と人間が事前にルールを定めておくことで、問題解決や推論を機械が実行するというもの。対して、データの解析を通じて機械自身がルールを見いだそうとするのが統計的学習理論だ。

例えば、人間の顔画像から「これが人間の顔だ」と認識するのはルールベースでは不可能だ。人によって顔の形も、照明の当たり方も、表情も髪型も違うからだ。しかし統計的学習ならば、機械自身が無数の顔画像からパターンを抽出、学習することで、初見の画像についても「これが人間の顔だ」と理解できるという。ルールベースの人工知能が主流だった時代も裏では統計的学習の研究が脈々と続けられてきた。それが近年のビッグデータの登場によって一気に学習が進むようになったのだ。「統計的学習において、我々がプログラムするのはルールではなくて、学習の仕方です。ルールベースでは1から10まで全部人間がプログラムする必要がありますが、統計的学習ではそれを減らし、一番メタな部分だけをプログラムします。すると、あとは機械がデータを見て勝手に賢くなっていく」

それはいわば「データがすべて」の世界。しかしデータそのものに誤りがあった場合はどうするのだろう。

「やはり機械もデータの誤りに応じた間違いをします。そのように細かいノイズに引っ張られてしまう現象を〝過学習〞といいます。ですが、統計と人工知能が強く関係しているのもこの点です。統計とはそもそも、ノイズを含んだデータを扱う学問。統計的学習にもデータの誤りに過度に引っ張られないように補正したり、弾いたりするテクニックがあります。これも私の研究領域の一つですね」

最終ゴールは人工知能の数理化

人工知能といえば車の自動運転や自然言語処理、金融、医療等々、応用分野の広さが盛んに謳われているところ。対照的に鈴木准教授は「よりプリミティブで、基礎的なもの」と自身の研究を位置づける。

「そもそも機械学習に何が学習できるのか、どこに限界があるのか。どんなデータを与えたらいいのか、どこまで学習スピードを早くできるのか。学生時代から、興味を持ったことに対して『この元はなんだろう?』と源流をたどっていくうちに、ここまできたという感じですね。

基礎研究ですから、多くの方が目にする〝製品〞になる段階では埋もれてしまう。しかし、機械学習の精度を上げる、楽に学習できるといったことが可能になるので、例えばエンジニアの方には嬉しいかもしれません」研究の究極のゴールは「人工知能の数理化」だ。人工知能というと、ともすると〝人間と同じように考える機械〞がイメージされるが、実際のところ人間のような論理的な思考、演繹的な思考は不得手だ。話題の深層学習にしても「『こうやったらうまくいった』という知見がたまっていく一方で、なぜそうなるか、我々の理解が追いついていない」という。

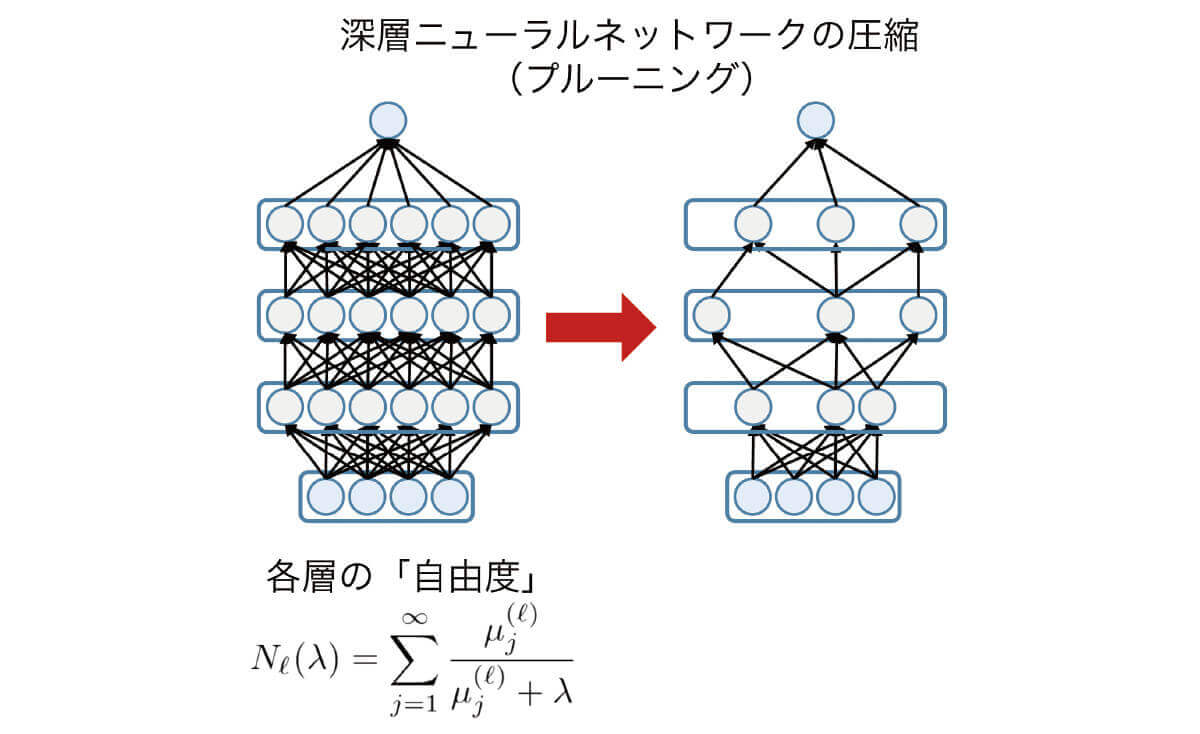

「それに、理論は1つできると様々なところに応用が効きます。実は人工知能は理論と応用がすごく近い分野でもあるんです。例えば学会でグーグルがこんな論文を出したといったらすぐにサービスが実装されます。同じように我々の基礎研究が〝モデル圧縮〞というニューラルネットワークを小さくする手法に応用できたりもします。今、応用領域がどんどん変化していることに対して、学問的に『深みを増さないまま先に進んでいる』と批判したくなる気持ちもある(笑)。しかし現に目の前で世の中が変わりつつある現場に居合わせることができるのは、面白い。ダイナミックですね」

「自分が本質的だと思うことを突き詰めることが重要」と語る鈴木准教授。「私が院生だった頃は数理的な研究は流行っていなかった。流行はありますがそこに依存せず、本質的なところを追いかけるべきだと思います」

注目の研究

NTTデータとの共同で進めているのが「モデル圧縮」の研究だ。鈴木准教授が研究している理論を用いると、人間の脳神経系をコンピュータ上で数理モデル化したニューラルネットワークを“小さく”できるという。「これにより、例えば組み込みデバイスにニューラルネットワークを入れやすくなります。消費メモリが3割減るだけでもかなり単価が下がりますし、相対的にマシンパワーも向上します。コンパクトなモデルで省電力に、しかも早く予測ができるようになる、ということです」

鈴木 大慈

准教授 博士(情報理工学)

すずき・たいじ/2009年、東京大学大学院情報理工学系研究科数理情報学専攻博士課程修了後、助教に。13年、東京工業大学大学院情報理工学研究科数理・計算科学専攻准教授などを経て、17年、東京大学大学院情報理工学系研究科数理情報学専攻 准教授。理化学研究所革新知能統合研究センター(AIP)深層学習理論チーム チームリーダー。

コメント